Google zet eerste stap op weg naar mobiele gebarentaal-app

Tot nu toe behaalde nog geen enkele computer goede resultaten met het vertalen van gebarentaal naar gesproken taal. Een door Google ontwikkelde technologie kan daar verandering in brengen. Volgens de verantwoordelijke Google-technici is voor hun vertaalapp niet meer nodig dan een smartphone.

De twee technici, Valentin Bazarevsky en Fan Zhang, ontwikkelden een app die gebruikt maakt van beeldherkenning, machine learning en een model van een hand om in real time handbewegingen te kunnen volgen. Beelden hiervan kun je zien op het blog van Bazarevsky en Zhang.

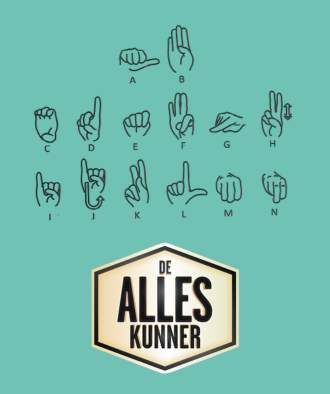

Handpalm als basis

Om het model van de hand te kunnen maken hebben de onderzoekers handmatig 30.000 foto’s van handgebaren geïnterpreteerd. Dat was nodig omdat het geautomatiseerd onderscheiden van verschillende handbewegingen via een computer lastig is. Delen van de hand schermen elkaar namelijk vaak af. Bovendien gaan handbewegingen heel snel en zitten er subtiele verschillen tussen gebaren. De twee Google-technici hebben dat probleem opgelost door voornamelijk de handpalm te observeren.

Open source

Een tweede algoritme zorgt voor de coördinaten van de knokkels en vingertoppen. Het algoritme analyseert ook de onderlinge afstanden van de vingers. Daarna wordt het handmodel vergeleken met de posities van de hand bij het gebruik van gebarentaal.

Een echte bruikbare vertaalapp is echter voorlopig nog niet beschikbaar. Daarvoor zou de app tegelijk twee handen moeten kunnen volgen, gezichtsuitdrukkingen kunnen interpreteren en de samenhang daartussen analyseren. De onderzoekers hebben de code als open source beschikbaar gesteld en hopen dat anderen het project verder oppakken en verbeteren.

Bron: AGConnect

Reacties